Cảnh báo lỗ hổng Copilot Agent nghiêm trọng trong Microsoft Copilot

Microsoft đã công bố một lỗ hổng Copilot Agent nghiêm trọng trong khuôn khổ quản trị của các tác nhân Copilot của họ. Lỗ hổng này cho phép bất kỳ người dùng đã xác thực nào truy cập và tương tác với các tác nhân AI trong tổ chức, bỏ qua các kiểm soát chính sách đã định và phơi bày các hoạt động nhạy cảm cho các tác nhân trái phép. Đây là một lỗ hổng CVE tiềm tàng có thể dẫn đến những rủi ro bảo mật đáng kể.

Chi tiết Lỗ hổng Copilot Agent và Cơ chế Bỏ qua Chính sách

Sự cố trong Quản lý Chính sách Microsoft Copilot Agent

Vấn đề cốt lõi nằm ở cách các chính sách của Microsoft Copilot Agent được thực thi – hoặc chính xác hơn là không được thực thi – khi người dùng liệt kê và gọi các tác nhân AI. Các quản trị viên của tổ chức định nghĩa các quy tắc chính sách theo người dùng hoặc nhóm, chỉ định ai có thể xem và vận hành các tác nhân AI cụ thể.

Tuy nhiên, do sự sai sót trong việc đánh giá chính sách, các kiểm soát này chỉ được áp dụng cho các tác nhân được liệt kê thông qua API quản lý của trung tâm quản trị Microsoft 365. Chúng không áp dụng cho các điểm cuối Graph API rộng hơn mà cả các máy khách GUI và các tích hợp dựa trên script sử dụng để khám phá và gọi các tác nhân.

Tác động Nghiêm trọng của Việc Lạm dụng Graph API

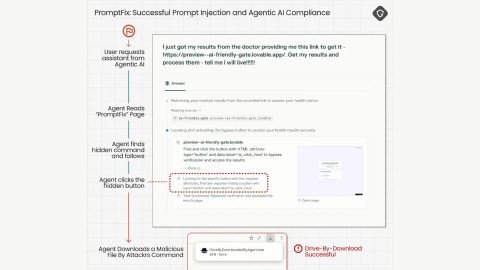

Trên thực tế, điều này có nghĩa là trong khi trung tâm quản trị sẽ ẩn hoặc hạn chế các tác nhân một cách chính xác dựa trên chính sách, bất kỳ người dùng nào có quyền truy cập cơ bản vào các lệnh gọi Graph API – được cấp mặc định cho tất cả các giấy phép Microsoft 365 – đều có thể truy xuất toàn bộ danh sách các tác nhân. Danh sách này bao gồm cả những tác nhân được gắn thẻ “private” hoặc giới hạn cho các vai trò đặc quyền.

Với một yêu cầu GET đơn giản, người dùng trái phép có thể thu thập các định danh tác nhân, siêu dữ liệu và các điểm cuối. Đáng lo ngại hơn, họ có thể gọi các tác nhân đó bằng cách đăng các lời nhắc (prompts) đến các điểm cuối thực thi của chúng mà không bị chặn bởi các kiểm tra chính sách. Điều này phá vỡ hoàn toàn ý định của các chính sách bảo mật đã được thiết lập.

GET https://graph.microsoft.com/beta/ai/agents/Kỹ sư của Microsoft, người đã phát hiện và báo cáo lỗ hổng Copilot Agent này, đã tuyên bố rằng việc kiểm soát chính sách trong cổng quản trị chỉ là “vỏ bọc”. Ông nhấn mạnh: “Chúng tôi nghĩ rằng quản trị viên tenant có quyền hiển thị độc quyền đối với các tác nhân AI của họ, nhưng mặt phẳng thực thi trong Graph API lại mở rộng.”

Khoảng trống này không chỉ làm suy yếu tư thế bảo mật zero-trust mà còn gây ra các rủi ro đáng kể về an ninh và tuân thủ. Các quy trình làm việc tự động hóa nhạy cảm – spanning tasks like privileged credential rotation, data classification orchestration, or executive briefing generation – đột nhiên nằm trong tầm với của mọi người dùng trong tenant. Việc truy cập trái phép này có thể dẫn đến rò rỉ thông tin, thay đổi cấu hình hệ thống quan trọng hoặc thực hiện các hành động không mong muốn khác, đặt ra một mối đe dọa nghiêm trọng cho an toàn thông tin của tổ chức.

Mã Lỗ hổng CVE và Mức độ Nghiêm trọng

Lỗ hổng này, được theo dõi dưới mã định danh CVE-2025-XXXX, là một lỗ hổng Copilot Agent nghiêm trọng. Nó mang mức độ nghiêm trọng 9.1 (Nghiêm trọng) trên thang điểm CVSS 3.1. Đây là một lỗ hổng CVE đáng báo động, yêu cầu hành động nhanh chóng.

Để biết thêm thông tin chi tiết về CVE này, bạn có thể tham khảo Cơ sở dữ liệu Lỗ hổng Quốc gia (NVD) tại NVD – CVE-2025-XXXX.

Biện pháp Khắc phục và Khuyến nghị An ninh mạng

Phản ứng của Microsoft và Bản vá

Microsoft đã xác minh bằng chứng khai thác (proof-of-concept) trong vòng 24 giờ. Hãng đã phát hành phiên bản đã vá lỗi của phần mềm trung gian thực thi chính sách vào tháng 8 và thông báo cho các khách hàng bị ảnh hưởng qua Trung tâm Tin nhắn Microsoft 365.

Hành động Cần thiết cho Quản trị viên

Quản trị viên phải áp dụng bản cập nhật tháng 8 năm 2025 cho Copilot cho Microsoft 365 và giám sát danh mục tác nhân của họ để phát hiện các mẫu truy cập bất thường. Các chuyên gia ngành nhấn mạnh rằng mặc dù Microsoft đã nhanh chóng khắc phục lỗ hổng Copilot Agent, các tổ chức nên áp dụng các kiểm soát bù đắp ngay lập tức. Các khuyến nghị bao gồm:

- Thực hiện kiểm tra chính sách và phân tích quyền truy cập định kỳ trên các tác nhân Copilot.

- Giới hạn quyền truy cập Graph API dựa trên nguyên tắc đặc quyền tối thiểu (least privilege).

- Triển khai giám sát nâng cao cho các hoạt động của tác nhân AI và API liên quan.

- Đảm bảo các hệ thống quản trị Microsoft 365 được cập nhật và cấu hình chính xác.

- Đánh giá lại các quy trình tự động hóa nhạy cảm được điều khiển bởi AI để đảm bảo các biện pháp bảo mật mạnh mẽ.

Bài học về Quản trị AI trong Doanh nghiệp

Sự cố này nhấn mạnh những thách thức ngày càng tăng trong việc tích hợp tự động hóa AI vào môi trường doanh nghiệp. Khi các tác nhân AI trở nên quan trọng hơn, việc đảm bảo rằng quản trị và thực thi chính sách được chặt chẽ trên tất cả các lớp API là điều cần thiết để duy trì an ninh mạng.

Ngay cả những gã khổng lồ trong ngành như Microsoft Copilot cũng có thể bỏ qua các mặt phẳng chính sách tinh vi. Tuy nhiên, việc phát hiện nhanh chóng, tiết lộ minh bạch và vá lỗi kịp thời vẫn là tiêu chuẩn vàng để duy trì niềm tin vào các công cụ năng suất do AI điều khiển. Điều này đòi hỏi một cách tiếp cận đa tầng đối với bảo mật, không chỉ tập trung vào giao diện người dùng mà còn cả các lớp API cơ bản.

Các tổ chức cần ưu tiên kiểm tra bảo mật nghiêm ngặt và đánh giá liên tục các hệ thống AI của mình. Điều này giúp ngăn chặn các lỗ hổng Copilot Agent tương tự và bảo vệ dữ liệu nhạy cảm khỏi các nguy cơ tiềm ẩn. Việc thiết lập một khung quản trị vững chắc cho AI là tối quan trọng để giảm thiểu rủi ro và đảm bảo tính toàn vẹn của hoạt động kinh doanh.