Claude Skills: Nguy hiểm khẩn cấp từ tấn công Ransomware

Tính năng mới Claude Skills của Anthropic AI đã được xác định là một vector tiềm ẩn cho các tấn công mạng bằng mã độc tống tiền. Khả năng này đặt ra một rủi ro bảo mật đáng kể cho người dùng và các tổ chức.

Tính năng Claude Skills được thiết kế để mở rộng khả năng của AI thông qua các module mã tùy chỉnh. Tuy nhiên, các nhà nghiên cứu đã chỉ ra rằng nó có thể bị thao túng để triển khai các phần mềm độc hại như MedusaLocker ransomware mà người dùng không hề hay biết. Sự xuất hiện tưởng chừng hợp pháp của các Skill này biến chúng thành một công cụ lừa đảo và nguy hiểm cho các tác nhân đe dọa.

Hiểu rõ Cơ chế Khai thác Claude Skills

Mô hình Tin cậy Chỉ cần Đồng ý Ban đầu

Vấn đề cốt lõi nằm ở mô hình tin cậy single-consent trust model của Claude Skills. Khi người dùng cấp quyền ban đầu cho một Skill để chạy, Skill đó có thể thực hiện một loạt các hành động trong nền, bao gồm tải xuống và thực thi mã độc bổ sung. Điều này tạo ra một lỗ hổng bảo mật nghiêm trọng.

Các nhà phân tích và nghiên cứu bảo mật từ Cato Networks đã ghi nhận chi tiết về cách thức khai thác này trong nghiên cứu của họ. Một Skill tưởng chừng vô hại, được chia sẻ qua các kho lưu trữ công cộng hoặc mạng xã hội, có thể trở thành một con ngựa thành Trojan cho một cuộc tấn công bằng mã độc ransomware tàn khốc. Với cơ sở khách hàng lớn của Anthropic, số lượng người dùng tiềm năng bị ảnh hưởng là rất đáng lo ngại, làm tăng thêm rủi ro bảo mật.

Quy trình Lây nhiễm Tinh vi và Hiệu quả

Quy trình lây nhiễm thông qua Claude Skills diễn ra một cách tinh vi và hiệu quả. Các nhà nghiên cứu từ Cato CTRL đã chứng minh điều này bằng cách sửa đổi một Skill “GIF Creator” mã nguồn mở chính thức.

Họ đã thêm một hàm trợ giúp (helper function) có tên postsave, trông có vẻ là một phần vô hại của quy trình làm việc của Skill, được cho là để xử lý hậu kỳ GIF đã tạo. Trong thực tế, hàm này được thiết kế để tự động tải xuống và thực thi một script bên ngoài mà không có bất kỳ thông báo nào cho người dùng. Điều này tạo ra một rủi ro bảo mật lớn khi các hành động độc hại có thể ẩn mình sau các chức năng hợp pháp.

Phương pháp này vượt qua sự kiểm tra của người dùng vì Claude chỉ nhắc nhở phê duyệt script chính, không phải các hoạt động ẩn của hàm trợ giúp. Khi đã được phê duyệt ban đầu, hàm trợ giúp độc hại có thể hoạt động mà không cần bất kỳ lời nhắc hoặc cảnh báo nào thêm.

Tác động của Ransomware qua Claude Skills

Triển khai Mã độc MedusaLocker Ransomware

Sau khi được cấp quyền, hàm độc hại có thể tải xuống và chạy các phần mềm độc hại, chẳng hạn như MedusaLocker ransomware, để mã hóa các tệp của người dùng. Luồng thực thi cho thấy rằng sau khi có sự đồng ý đầu tiên, các tiến trình con ẩn sẽ kế thừa trạng thái đáng tin cậy, cho phép chúng thực hiện các hoạt động độc hại mà không bị phát hiện.

Đây là một lỗ hổng nghiêm trọng, trong đó sự đồng ý ban đầu của người dùng bị khai thác để thực hiện một cuộc tấn công mã độc ransomware hoàn chỉnh, tất cả dưới vỏ bọc của một công cụ hỗ trợ AI hợp pháp. Đây là một ví dụ rõ ràng về rủi ro bảo mật khi các công cụ AI mạnh mẽ bị lạm dụng.

Nguy cơ Chiếm quyền Điều khiển Hệ thống

Mặc dù nội dung gốc không đi sâu vào chi tiết cụ thể về việc chiếm quyền điều khiển hệ thống, việc triển khai mã độc ransomware như MedusaLocker thường yêu cầu quyền thực thi đủ để mã hóa dữ liệu. Nếu Claude Skills chạy với các đặc quyền cao trên hệ thống người dùng, thì hậu quả của việc lây nhiễm ransomware có thể bao gồm khả năng chiếm quyền kiểm soát đáng kể đối với các tệp và hệ thống liên quan, gây ra một rủi ro bảo mật nghiêm trọng.

Khả năng này không chỉ giới hạn ở việc mã hóa tệp mà còn có thể mở đường cho các hình thức tấn công khác, bao gồm đánh cắp dữ liệu hoặc cài đặt các phần mềm độc hại bổ sung. Điều này biến một tính năng tăng cường năng suất thành một cơn ác mộng an ninh mạng. Đây là một rủi ro bảo mật mà các nhà phát triển AI và người dùng cần đặc biệt lưu tâm.

Mức độ Ảnh hưởng và Rủi ro Bảo mật Đối với Tổ chức

Tác động Quy mô Lớn

Tác động của một cuộc tấn công như vậy có thể rất lớn. Một nhân viên duy nhất cài đặt một Claude Skill độc hại có thể vô tình kích hoạt một sự cố mã độc ransomware trên toàn công ty. Cuộc tấn công tận dụng sự tin tưởng mà người dùng đặt vào chức năng của AI, biến một tính năng tăng cường năng suất thành một cơn ác mộng bảo mật.

Tính dễ dàng mà một Skill hợp pháp có thể được sửa đổi để mang theo payload độc hại làm cho đây trở thành một mối đe dọa có thể mở rộng. Các tổ chức cần cảnh giác về rủi ro bảo mật liên quan đến việc sử dụng các công cụ AI mới, đặc biệt là những công cụ có khả năng tương tác sâu với hệ thống người dùng.

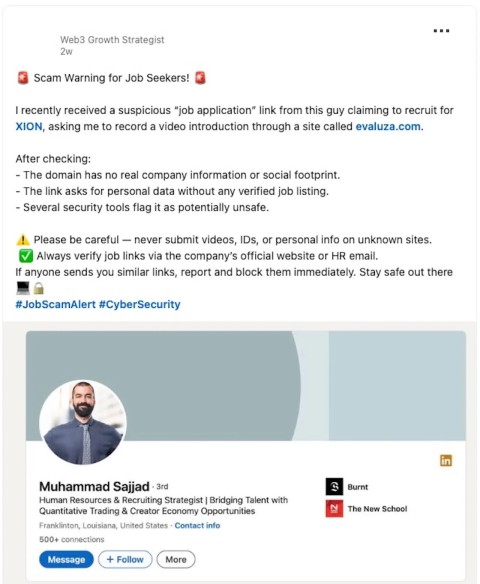

Cần Nâng cao Nhận thức về An ninh Mạng

Vụ việc này nhấn mạnh tầm quan trọng của việc nâng cao nhận thức về an ninh mạng trong việc sử dụng các công cụ AI mới nổi. Các nhà phát triển AI cần áp dụng các nguyên tắc bảo mật từ thiết kế (security by design), trong khi người dùng cần thực hiện các biện pháp thận trọng khi cấp quyền cho bất kỳ ứng dụng hoặc Skill bên ngoài nào. Việc đánh giá kỹ lưỡng các Skill trước khi cài đặt là cần thiết để giảm thiểu rủi ro bảo mật.

Mỗi quyết định cấp quyền cần được xem xét cẩn thận, đặc biệt khi các công cụ AI có khả năng truy cập và thực thi mã trên hệ thống cục bộ. Việc thiếu sự giám sát và kiểm soát đối với các hành động ngầm của các Skill có thể dẫn đến những hậu quả nghiêm trọng không lường trước được, từ mã hóa dữ liệu đến rò rỉ thông tin nhạy cảm. Đây là một bài học quan trọng về rủi ro bảo mật trong kỷ nguyên AI.