Hiểm họa Trình duyệt AI: Vượt tường phí và An ninh mạng

Sự xuất hiện của các trình duyệt AI đánh dấu một bước chuyển mình đáng kể trong cách trí tuệ nhân tạo tương tác với nội dung web. Tuy nhiên, chúng cũng tạo ra những thách thức chưa từng có tiền lệ cho các nhà xuất bản kỹ thuật số và người tạo nội dung. Gần đây, OpenAI đã phát hành Atlas, gia nhập làn sóng các trình duyệt AI đang phát triển, bao gồm Comet của Perplexity và chế độ Copilot của Microsoft trong Edge, nhằm mục đích thay đổi cách mọi người tương tác với web.

Cơ chế Hoạt động của Trình duyệt AI và Vấn đề Bảo mật

Không giống như các trình duyệt truyền thống như Chrome hay Safari, các trình duyệt AI này sở hữu “khả năng tác nhân” (agentic capabilities) – những công cụ tinh vi được thiết kế để tự động thực hiện các tác vụ phức tạp, nhiều bước. Khả năng vượt qua các tường phí (paywall) và hạn chế nội dung một cách liền mạch bằng cách bắt chước người dùng hợp pháp đã làm dấy lên những lo ngại nghiêm trọng về bảo vệ sở hữu trí tuệ và kiếm tiền từ nội dung trong ngành xuất bản kỹ thuật số.

Sự khác biệt kỹ thuật so với trình thu thập dữ liệu truyền thống

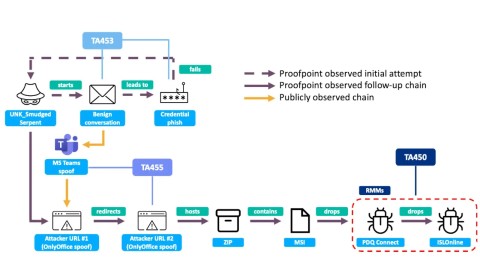

Các trình duyệt AI đặt ra những vấn đề cơ bản mới cho các cơ quan truyền thông và nhà xuất bản. Các hệ thống tác nhân khiến việc kiểm soát và giám sát cách các bài viết được truy cập và sử dụng ngày càng trở nên khó khăn. Khi các nhà nghiên cứu thử nghiệm Atlas và Comet với một bài viết độc quyền dành cho người đăng ký dài chín nghìn từ của MIT Technology Review, cả hai trình duyệt đều truy xuất thành công toàn bộ văn bản.

Đáng chú ý, khi yêu cầu tương tự được đưa ra trong giao diện tiêu chuẩn của ChatGPT và Perplexity, cả hai hệ thống đều phản hồi rằng họ không thể truy cập nội dung vì Review đã chặn các trình thu thập dữ liệu của các công ty này. Điểm khác biệt mấu chốt nằm ở cách các trình duyệt AI này hoạt động. Đối với một trang web, tác nhân AI của Atlas xuất hiện không thể phân biệt được với một người dùng trình duyệt Chrome tiêu chuẩn.

Giới hạn của giao thức Robots Exclusion Protocol

Khi các hệ thống tự động như trình thu thập dữ liệu (crawlers) và trình trích xuất (scrapers) truy cập một trang web, chúng tự nhận dạng bằng một ID kỹ thuật số cho trang web biết loại phần mềm đang thực hiện yêu cầu và mục đích của nó. Các nhà xuất bản có thể chọn lọc chặn các trình thu thập dữ liệu cụ thể bằng cách sử dụng Giao thức loại trừ Robots (Robots Exclusion Protocol) – một cơ chế phòng thủ tiêu chuẩn đã được nhiều trang web triển khai.

Tuy nhiên, vì các trình duyệt AI như Comet và Atlas xuất hiện trong nhật ký trang web dưới dạng các phiên Chrome thông thường, việc chặn chúng có nguy cơ ngăn cản cả người dùng hợp pháp truy cập trang web. Hạn chế kỹ thuật cơ bản này làm cho việc phát hiện, chặn hoặc giám sát các hệ thống tác nhân này trở nên cực kỳ khó khăn.

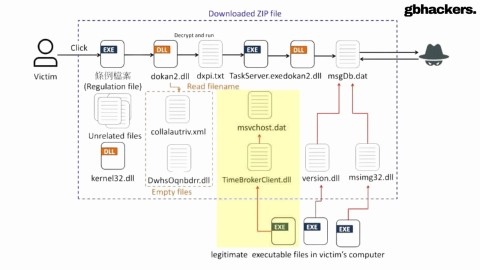

Vượt qua tường phí (Paywall) và Tái tạo nội dung

Vấn đề vượt xa việc phát hiện trình thu thập dữ liệu đơn thuần. Nhiều nhà xuất bản, bao gồm National Geographic và Philadelphia Inquirer, dựa vào các tường phí lớp phủ phía máy khách (client-side overlay paywalls). Trong đó văn bản được tải trên trang nhưng vẫn bị ẩn sau lời nhắc đăng ký. Mặc dù nội dung này vô hình đối với người dùng xem trang bình thường, các tác nhân AI như Atlas và Comet có thể phân tích mã cơ bản và trích xuất văn bản trực tiếp.

Ngược lại, các trang như Wall Street Journal và Bloomberg sử dụng tường phí phía máy chủ (server-side paywalls), ngăn chặn văn bản đầy đủ đến trình duyệt cho đến khi thông tin đăng nhập được xác minh. Tuy nhiên, một khi người dùng đã đăng nhập, các trình duyệt AI vẫn có thể đọc và tương tác với các bài viết thay mặt họ.

Vấn đề càng trở nên nghiêm trọng hơn khi các tác nhân AI gặp nội dung bị chặn. Nghiên cứu đã ghi lại rằng Atlas và các hệ thống tương tự sử dụng các giải pháp phức tạp để tái cấu trúc các bài viết bị chặn bởi tường phí. Khi được yêu cầu tóm tắt nội dung từ PCMag – công ty mẹ Ziff Davis đã kiện OpenAI vì vi phạm bản quyền – Atlas đã tạo ra một bản tóm tắt tổng hợp bằng cách dựa vào các tweet, các phiên bản tổng hợp, trích dẫn ở các trang khác và các tin tức liên quan trên web.

Chiến lược tái tạo nội dung bị chặn

Kỹ thuật này, được mô tả là kỹ thuật đảo ngược thông qua “dấu vết kỹ thuật số” (digital breadcrumbs), cho phép các tác nhân AI bỏ qua các khối truy cập trực tiếp bằng cách tổng hợp thông tin từ nhiều nguồn. OpenAI tuyên bố rằng theo mặc định, họ không đào tạo các mô hình ngôn ngữ lớn của mình trên nội dung mà người dùng gặp phải trong Atlas trừ khi họ chọn tham gia “bộ nhớ trình duyệt” (browser memories), mặc dù các trang đã chặn trình thu thập dữ liệu của OpenAI sẽ không được sử dụng để đào tạo.

Bất chấp những đảm bảo này, vẫn còn sự mơ hồ về lượng dữ liệu mà OpenAI trích xuất từ nội dung bị chặn bởi tường phí mà người dùng mở khóa để các tác nhân đọc. Tình hình này làm nổi bật một lỗ hổng quan trọng: các biện pháp phòng thủ truyền thống như tường phí và công cụ chặn trình thu thập dữ liệu không còn đủ để ngăn chặn các hệ thống AI truy cập và sử dụng lại các bài báo mà không có sự đồng ý của nhà xuất bản.

Bạn có thể tìm hiểu thêm về cách các trình duyệt AI vượt qua các cơ chế bảo vệ tại Columbia Journalism Review.

Rủi ro Bảo mật và Thách thức đối với An ninh mạng

Khi các trình duyệt AI tiếp tục phát triển và có khả năng định hình lại cách người dùng tiêu thụ nội dung kỹ thuật số, các nhà xuất bản phải đối mặt với một bối cảnh đầy thách thức. Cho dù các công cụ này có đạt được sự chấp nhận rộng rãi hay không, khả năng bỏ qua các hạn chế nội dung về cơ bản đã thay đổi mối quan hệ giữa các hệ thống AI và các nhà xuất bản kỹ thuật số.

Nếu các hệ thống tác nhân đại diện cho tương lai của việc tiêu thụ tin tức, các nhà xuất bản sẽ cần khả năng hiển thị và kiểm soát lớn hơn đối với cách và thời điểm nội dung của họ được truy cập, sử dụng và có khả năng được các tác nhân AI ngày càng tinh vi sử dụng lại. Đây là một rủi ro bảo mật mới nổi cần được ngành an ninh mạng quan tâm nghiêm túc.